Now Reading: Wann man KI im Modellieren vertrauen sollte: Eine auf Forschung basierende Perspektive

-

01

Wann man KI im Modellieren vertrauen sollte: Eine auf Forschung basierende Perspektive

Wann man KI im Modellieren vertrauen sollte: Eine auf Forschung basierende Perspektive

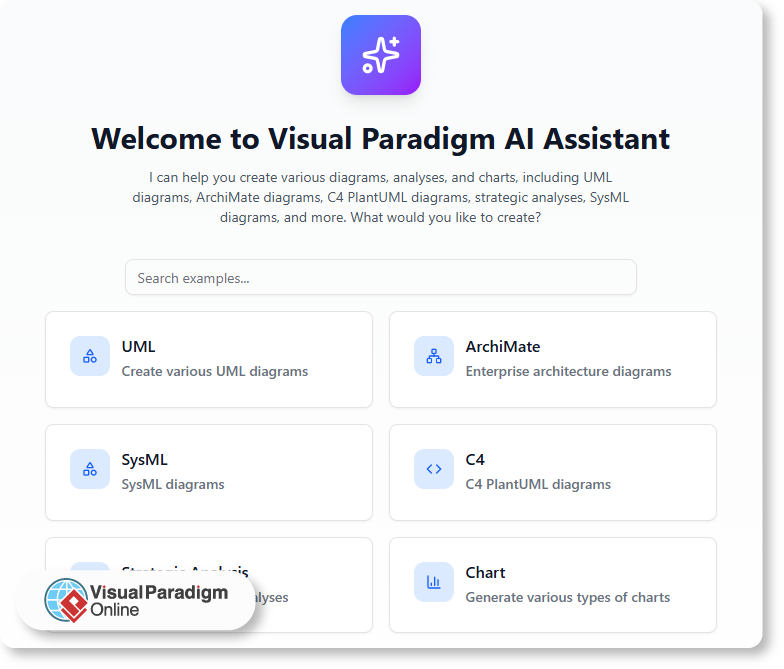

Die Integration künstlicher Intelligenz in Modellierungsworkflows hat neue Effizienzpfade eröffnet, insbesondere bei der Diagrammerstellung. KI-gestützte Modellierungstools bieten nun automatisierte Diagrammerstellung über ein breites Spektrum an Standards, von UML bis ArchiMate und SWOT-Analyse. Doch während diese Systeme beeindruckende Mustererkennung und strukturelle Konsistenz zeigen, stellen ihre Ausgaben keine vollständigen Modelle dar. Der Unterschied zwischenautomatisierte Ausgabe und Modellüberprüfungbleibt ein entscheidender Faktor bei der angewandten Analyse.

Dieser Artikel untersucht die theoretischen und praktischen Grenzen der KI im Modellieren und konzentriert sich darauf, wann automatisierte Ausgaben vertrauenswürdig sind und wann menschliche Nachbearbeitung unverzichtbar ist. Durch die Analyse von Diagrammtypen, Nutzerabsichten und interpretativen Kontexten legen wir ein Rahmenwerk für die verantwortungsvolle Nutzung von KI in Modellierungsumgebungen fest.

Theoretische Grundlagen der KI im Modellieren

Moderne KI-Chatbots für das Modellieren arbeiten durch domänenspezifische Sprachmodellierung, die auf bestehenden Unternehmensdiagrammen und Modellierungsstandards trainiert wurde. Diese Systeme basieren auf formalen Modellierungssprachen – wie UML, SysML und ArchiMate –, bei denen Syntax, Semantik und Struktur gut definiert sind. Die KI-Modelle lernen aus annotierten Beispielen, wodurch sie Diagramme generieren können, die anerkannten Standards entsprechen.

Beispielsweise wendet das System bei einer Anfrage eines Benutzers nach einem UML-Sequenzdiagramm für einen „Kundenbestellfluss“ bekannte Verhaltensmuster und Interaktionsregeln an, um die Sequenz zu strukturieren. Ähnlich verhält es sich in der Unternehmensarchitektur, wo KI-generierte ArchiMate-Sichten etablierte Perspektiven wie „Business-Technologie-Ausrichtung“ oder „Ressourcenallokation“ berücksichtigen. Diese Ausgaben sind nicht zufällig; sie sind das Ergebnis von musterbasiertem Inferenz aus großskaligen Modellierungsdatenbanken.

Trotzdem verfügt die KI nicht über die Fähigkeit, kontextuelle Gültigkeit—einen entscheidenden Bestandteil im Modellieren, der die Ausrichtung an Geschäftszielen, Erwartungen von Stakeholdern oder operativen Beschränkungen sicherstellt. Diese Beschränkung erfordert einen menschlichen Eingriff im Prozess.

Wann KI-Ausgaben vertrauenswürdig sind

Die KI-gestützte Diagrammerstellung ist zuverlässig in Szenarien, in denen die Eingabe klar, begrenzt und an etablierten Modellierungsprinzipien ausgerichtet ist. In solchen Fällen kann die KI strukturell solide Diagramme erzeugen, die den Standardregeln folgen. Beispiele sind:

- Automatisierte Diagrammerstellung für gängige Geschäftsframeworks wie die SWOT-Analyse oder die Ansoff-Matrix, wenn die Eingabe bekannte Dimensionen widerspiegelt.

- UML-Nutzungsfalldiagramme für Systeme mit klar definierten Akteuren und Interaktionen (z. B. „ein Student meldet sich für einen Kurs an“).

- C4-Modell-Elemente wie Systemkontext- oder Bereitstellungsdigramme, bei denen die Beziehungen zwischen Komponenten durch Architekturmuster gut definiert sind.

Diese Fälle repräsentieren Szenarien mit geringem Absichtsgrad, bei denen der Nutzer bekannte Konzepte visualisieren möchte. Die Stärke der KI liegt in der Erzeugung konsistenter, standardisierter Ausgaben. Beispielsweise erzeugt das Diagramm, wenn ein Forscher fragt: „Erstellen Sie ein Bereitstellungsdigramm für eine mikroservicesbasierte E-Commerce-Plattform“, korrekt platzierte Knoten, Kommunikationslinien und Servicegrenzen – im Einklang mit branchenüblichen Best Practices.

In diesen Fällen dient die KI-Ausgabe als Ausgangspunkt für weitere Analyse und reduziert die kognitive Belastung der initialen Modellierung.

Wann menschliche Überprüfung unverzichtbar ist

Trotz struktureller Genauigkeit verfehlen KI-generierte Diagramme oft interpretative Nuancen. Dies gilt besonders in komplexen Bereichen wie der Unternehmensarchitektur oder der strategischen Planung, wo Kontext, Absicht und organisatorische Dynamiken die Gültigkeit des Modells prägen.

Beispielsweise kann eine KI-generierte SWOT-Analyse Stärken und Bedrohungen korrekt identifizieren, kann aber nicht beurteilen, ob diese Faktoren umsetzbar, messbar oder mit der langfristigen Geschäftsstrategie vereinbar sind. Ebenso kann ein KI-generiertes SysML-Anforderungsdiagramm korrekte Rückverfolgbarkeit zeigen, vermag aber die Prioritäten von Stakeholdern oder regulatorische Abhängigkeiten nicht zu erfassen.

Diese Lücke ist kein Fehler im KI-Modell – sie spiegelt eine grundlegende Beschränkung des Umfangs automatisierten Schließens wider. Daher muss wann man KI im Modellieren vertrauen solltedurch die Perspektive des Modellzwecks bewertet werden. In hochriskanten Entscheidungssituationen – wie Systemgestaltung, strategische Planung oder regulatorische Compliance – ist die menschliche Überprüfung von KI-Ausgaben nicht optional, sondern unverzichtbar.

Darüber hinaus der Begriff von “KI im Vergleich zu menschlicher Kontrolle bei der Modellierung wird in Szenarien deutlich, in denen interpretatives Urteil erforderlich ist. Zum Beispiel, wenn ein Business Analyst fragt: „Wie realisiere ich diese Bereitstellungskonfiguration?“, kann die KI die Knoten und Verbindungen beschreiben, aber sie kann nicht bestimmen, ob die Konfiguration Skalierbarkeit, Failover oder Sicherheitsrichtlinien unterstützt. Nur ein Mensch mit fachlichem Wissen kann diese Abwägungen bewerten.

Dies stärkt das Prinzip vonmenschliche Überprüfung von KI-Ausgaben als Schutz vor vereinfachten oder kontextuell irrelevanten Diagrammen.

Die Rolle der KI-gestützten Diagramm-Editierung

Während die erste Erstellung automatisiert ist, bleibt die Feinabstimmung eine menschlich geführte Tätigkeit. Benutzer können Änderungen wie Umbenennung von Elementen, Anpassung von Formen oder Hinzufügen von Einschränkungen anfordern. Diese Fähigkeit ermöglicht iteratives Modellieren, bei dem die KI als kognitiver Co-Pilot fungiert, nicht als Entscheidungsträger.

Zum Beispiel kann ein von der KI generiertes Aktivitätsdiagramm für einen Kreditantrag zunächst Schritte falsch gruppieren. Ein Mensch kann die Reihenfolge dann durch Anpassung der Flusspfeile oder Hinzufügen von Bedingungen verfeinern. Dieser Prozess zeigtKI-gestützte Diagramm-Editierung als Werkzeug für iterative Validierung, nicht als Ersatz.

Solche Fähigkeiten unterstützen ein hybrides Arbeitsmodell – bei dem die KI die Hauptlast der Diagrammerstellung übernimmt, während Menschen die Verantwortung für Interpretation, Validierung und Ausrichtung an Geschäftsziele übernehmen.

Praktische Anwendungen über verschiedene Modellierungsstandards hinweg

| Diagrammtyp | Stärke der KI-Ausgabe | Bedarf an menschlicher Feinabstimmung |

|---|---|---|

| UML-Anwendungsfalldiagramm | Stark bei der Zuordnung von Akteuren und Rollen | Erfordert die Validierung des Geschäftskontexts |

| ArchiMate-Sicht | Strukturell korrekt | Erfordert Ausrichtung an der Unternehmensstrategie |

| SWOT-Analyse | Genauere Kategorisierung | Erfordert Urteilskraft bezüglich strategischer Relevanz |

| C4-Systemkontext | Klare Beziehungen zwischen Komponenten | Erfordert die Validierung von Grenzdefinitionen |

| SysML-Anforderung | Nachvollziehbare Struktur | Erfordert die Validierung der Prioritäten durch Stakeholder |

Diese Beobachtungen bestätigen einen zentralen Erkenntnisgewinn: Künstliche Intelligenz im Diagramm erstellen ist kein Ersatz für Modellierungskenntnisse. Stattdessen fungiert sie als kognitiver Erweiterung, die die Zeit zur Erstellung erster Modelle reduziert, während die Notwendigkeit einer menschlichen Aufsicht erhalten bleibt.

Ein Rahmenwerk für Entscheidungsfindung

Um festzustellen, wann man der KI im Modellieren vertrauen kann, sollten Praktiker die folgenden Kriterien berücksichtigen:

- Klarheit der Eingabe: Ist die Beschreibung des Benutzers eindeutig, abgegrenzt und frei von Mehrdeutigkeiten?

- Zweck des Modells: Wird das Diagramm zur Dokumentation, Kommunikation oder Entscheidungsfindung verwendet?

- Interessenvertreter-Kontext: Gibt es unausgesprochene Beschränkungen (z. B. Compliance, veraltete Systeme), die die KI nicht interpretieren kann?

- Bedarf an Interpretation: Erfordert das Diagramm Urteilsbildung hinsichtlich Machbarkeit, Auswirkungen oder Priorität?

Wenn diese Faktoren auf geringe Komplexität und bekannte Bereiche hinweisen, kann die KI als zuverlässige erste Ausgabe dienen. Wenn das Modell Interpretation, Strategie oder fachspezifische Beschränkungen beinhaltet, wird eine menschliche Überprüfung unerlässlich.

Dieses Rahmenwerk unterstützt einen ausgewogenen Ansatz für KI im Vergleich zu menschlicher Kontrolle im Modellieren, bei dem Automatisierung effizient genutzt wird und menschliche Urteilskraft dort bewahrt bleibt, wo sie am wichtigsten ist.

Fazit

KI-gestützte Modellierungswerkzeuge, wie sie von Visual Paradigm angeboten werden, bieten durch automatisierte Diagrammerstellung und kontextbewusste Vorschläge erheblichen Wert. Die theoretischen und praktischen Grundlagen der Modellierung erfordern jedoch mehr als nur strukturelle Genauigkeit. Sie verlangen interpretative Tiefe, Kontextbewusstsein und strategische Ausrichtung – Fähigkeiten, die weiterhin fest im Bereich menschlicher Expertise liegen.

Die effektivsten Modellierungsprozesse integrieren die KI als Co-Processor: Erstellung von Ausgangsstrukturen, Vorschlag von Mustern und Bereitstellung von Erklärungen. Wenn menschliche Fachkräfte eingreifen, um zu validieren, zu verfeinern und zu interpretieren, wird das Endprodukt sowohl genau als auch bedeutungsvoll.

Für Forscher und Praktiker stellt dies eine Verschiebung von Werkzeugabhängigkeitzu kooperativer Modellierung. Die Zukunft der Diagrammgestaltung liegt nicht darin, menschliches Urteil durch Automatisierung zu ersetzen, sondern darin, es zu verbessern.

Für diejenigen, die KI-Chatbots für die Modellierung erforschen, ist es unerlässlich zu erkennen, dass die wertvollsten Anwendungen dann entstehen, wenn die KI-Ausgabe als Ausgangspunkt genutzt wird – stets unterworfen einer menschlichen Überprüfung und kontextuellen Validierung.

Häufig gestellte Fragen

F1: Kann die KI ein gültiges Unternehmensarchitekturmodell ohne menschliche Eingabe erstellen?

Nein. Obwohl die KI ArchiMate-Darstellungen erstellen kann, die strukturellen Regeln folgen, erfordert die Ausrichtung an Geschäftsstrategie, Governance oder organisatorischen Veränderungen eine menschliche Bewertung.

F2: Ist die automatisierte Diagrammerstellung zuverlässig für strategische Modelle wie SWOT?

Die KI kann Stärken und Bedrohungen erkennen, kann aber deren strategische Bedeutung oder Umsetzbarkeit nicht bestimmen. Eine menschliche Analyse ist notwendig.

F3: Welche Rolle spielt der Benutzer bei der KI-gestützten Diagrammerstellung?

Der Benutzer liefert Kontext, verfeinert Ausgaben und validiert Interpretationen. Die KI ist bei Modellierungsentscheidungen nicht autonom.

F4: Wie verbessert die KI-gestützte Diagrammbearbeitung die Effizienz der Modellierung?

Es ermöglicht Benutzern, die Struktur zu korrigieren, Elemente zu benennen oder Beziehungen anzupassen, ohne von vorne beginnen zu müssen – was die Modellierungszeit reduziert, ohne die Genauigkeit zu beeinträchtigen.

F5: Wann sollte ich auf KI im Gegensatz zur menschlichen Modellierung zurückgreifen?

Vertrauen Sie der KI bei ersten, standardisierten Diagrammentwürfen. Verlassen Sie sich auf menschliches Urteil bei Interpretation, Validierung und Entscheidungsebene der Modellierung.

F6: Kann die KI ein Diagramm in natürlicher Sprache erklären?

Ja, die KI kann Erklärungen generieren und Nachfragen vorschlagen, beispielsweise „Wie würden Sie diese Bereitstellungskonfiguration umsetzen?“ Die Tiefe und Genauigkeit hängen jedoch von der Fähigkeit des Benutzers ab, die Ausgabe zu interpretieren und zu validieren.

Für erweiterte Diagrammfunktionen, einschließlich Desktop-Bearbeitung und vollständige Modellierungsabläufe, besuchen Sie die Visual Paradigm-Website.

Um mit der Echtzeit-Experimentierung mit KI-gestützter Modellierung zu beginnen, besuchen Sie die KI-Chatbot für die Modellierung und erkunden Sie, wie die automatisierte Diagrammerstellung und die menschliche Überprüfung zusammenarbeiten.